Apple Silicon vs NVIDIA CUDA : Comparatif IA 2025, Benchmarks, Avantages et Limites

Depuis l’arrivée du premier processeur Apple Silicon M1 en 2020, jusqu’aux récents M4, Apple a profondément modifié son approche du calcul pour l’intelligence artificielle. En seulement quelques années, la marque est passée d’architectures proches des standards du marché à un System on a Chip (SoC) intégrant CPU, GPU, Neural Engine et mémoire unifiée à très haut débit — un véritable changement de paradigme par rapport aux systèmes traditionnels.

En face, NVIDIA CUDA, lancé en 2006, reste fidèle à son modèle : GPU dédié, VRAM séparée et calcul massivement parallèle. Cette architecture, soutenue par un écosystème logiciel d’une maturité exceptionnelle, continue de dominer l’entraînement de modèles à grande échelle.

Ces deux approches incarnent aujourd’hui deux visions distinctes :

- Apple Silicon mise sur l’intégration matérielle, la mémoire partagée et l’efficacité énergétique, idéale pour l’IA locale et la portabilité.

- CUDA privilégie la puissance brute et la spécialisation matérielle, optimisée pour les charges de travail massives et le cloud.

L’objectif de cet article est de déterminer dans quels cas Apple Silicon peut surpasser CUDA, et dans quelles situations CUDA conserve un avantage décisif. Nous analyserons leurs architectures, performances, outils, limites et cas d’usage réels pour offrir une vision claire et actualisée en 2025.

Apple Silicon vs NVIDIA CUDA

| Critère | Apple Silicon (M1 → M4) | NVIDIA CUDA (RTX, H100…) |

|---|---|---|

| Architecture | SoC intégré (CPU, GPU, Neural Engine, mémoire unifiée) | CPU + GPU dédié avec VRAM séparée |

| Mémoire | Partagée, bande passante commune (jusqu’à 546 Go/s) | VRAM dédiée très rapide (jusqu’à 1 To/s sur modèles haut de gamme) |

| Performance brute | Moins de FLOPS, mais optimisation par intégration | Puissance maximale en calcul parallèle |

| Efficacité énergétique | Très élevée, idéal pour l’IA locale | Plus énergivore, optimisé pour data centers |

| Écosystème logiciel | MLX, MPS, Core ML (maturité en progression) | PyTorch/TensorFlow optimisés CUDA, outils matures |

| Cas d’usage fort | Inférence locale, prototypage rapide | Entraînement massif, production cloud |

- 1. Architecture : Deux Philosophies Opposées

- 2. Performances Comparées en IA

- 3. Outils et Frameworks

- 4. Limites et Contraintes Spécifiques

- 5. Cas d’Usage et Retours d’Expérience

- 6. Perspectives

- Conclusion : Pour Développer une Application d’IA

1. Architecture : Deux Philosophies Opposées

1.1. NVIDIA CUDA — Puissance Brute et Écosystème Mature

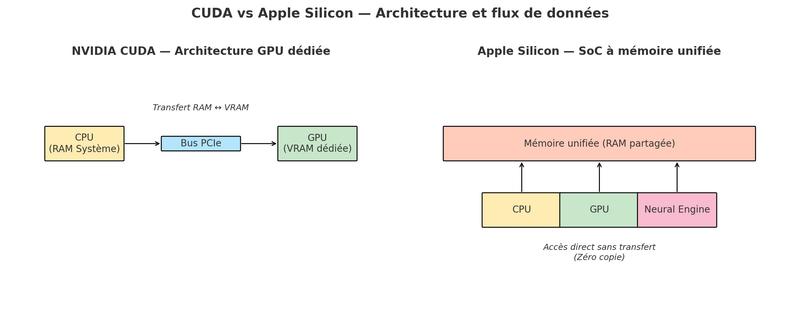

Depuis sa création en 2006, CUDA (Compute Unified Device Architecture) est devenu le standard de facto pour le calcul massivement parallèle, en particulier dans le domaine de l’intelligence artificielle et du machine learning. L’architecture CUDA repose sur un GPU dédié, doté de sa propre mémoire vidéo (VRAM) à très haut débit, relié au processeur central (CPU) via un bus PCI Express (PCIe).

Principe de Fonctionnement

- CPU et RAM système : exécutent le code général, préparent et organisent les données.

- GPU et VRAM : réalisent les calculs massivement parallèles (multiplications matricielles, convolutions, etc.).

- Communication : les données doivent être transférées entre RAM et VRAM via PCIe.

Forces

- Puissance brute : les cartes NVIDIA haut de gamme comme la RTX 4090 ou l’H100 atteignent des niveaux de calcul en téraflops voire pétaflops, avec des milliers de cœurs CUDA.

- VRAM dédiée : large capacité (24 à 80 Go sur certaines cartes), bande passante jusqu’à 1 To/s.

- Écosystème logiciel : compatibilité native et optimisations poussées dans PyTorch, TensorFlow, JAX, ainsi que bibliothèques spécialisées comme cuDNN, TensorRT, NCCL, FlashAttention ou bitsandbytes.

- Scalabilité : possibilité d’assembler plusieurs GPU via NVLink pour former des clusters d’entraînement massifs.

Limites

- Transferts CPU ↔ GPU : ces échanges introduisent une latence, surtout pour des workflows nécessitant des passages fréquents entre CPU et GPU.

- Segmentation mémoire : la VRAM est isolée, donc un modèle dépassant la capacité GPU nécessite du partitionnement ou de l’offloading (avec baisse de performances).

- Consommation énergétique : les cartes haut de gamme consomment souvent 300 à 700 W, un facteur clé en coûts d’exploitation et en refroidissement.

1.2. Apple Silicon — SoC à Mémoire Unifiée

Apple a choisi une approche radicalement différente en regroupant tous les composants principaux sur une même puce, un System on a Chip (SoC). CPU, GPU, Neural Engine, coprocesseurs matriciels AMX (Apple Matrix Extension) ou SME (Scalable Matrix Extension), contrôleurs mémoire et accélérateurs spécialisés partagent un même espace mémoire physique : c’est l’architecture à mémoire unifiée (Unified Memory Architecture – UMA).

Principe de Fonctionnement

- Mémoire unique : CPU, GPU et Neural Engine accèdent directement aux mêmes données en RAM.

- Zéro copie : inutile de transférer un tenseur du CPU vers le GPU, il est directement accessible par tous.

- Optimisation interne : le système décide dynamiquement quelle unité exécute une tâche (GPU, AMX, Neural Engine), selon le type d’opération.

Forces

- Efficacité énergétique : un M3 Max ou M4 Max consomme entre 40 et 80 W en charge lourde, tout en offrant des performances compétitives pour l’inférence et le prototypage.

- Simplicité logicielle : moins de gestion manuelle des transferts mémoire ; code plus simple et plus stable.

- Bande passante élevée : jusqu’à 546 Go/s (M4 Max), partagée par toutes les unités de calcul.

- Polyvalence du SoC : les tâches non purement GPU peuvent être accélérées par l’AMX ou le Neural Engine.

Limites

- Puissance brute inférieure : en calcul pur (FLOPS), les GPU NVIDIA haut de gamme restent largement devant, notamment pour l’entraînement massif.

- Mémoire GPU plafonnée : le GPU ne peut utiliser qu’environ 75 % de la RAM système (ex. : ~96 Go utilisables sur un Mac 128 Go).

- Écosystème moins mature : bien que MLX, MPS et Core ML progressent vite, certaines bibliothèques optimisées CUDA n’ont pas d’équivalent direct sur Apple Silicon.

En résumé : CUDA et Apple Silicon incarnent deux visions opposées. CUDA maximise la puissance brute avec une architecture spécialisée, optimisée pour des charges de calcul gigantesques, mais énergivore et dépendante de transferts mémoire. Apple Silicon mise sur une intégration totale et la fluidité des échanges mémoire, au prix d’une puissance brute plus limitée mais avec une efficacité énergétique et une simplicité de développement incomparables.

2. Performances Comparées en IA

2.1. Entraînement

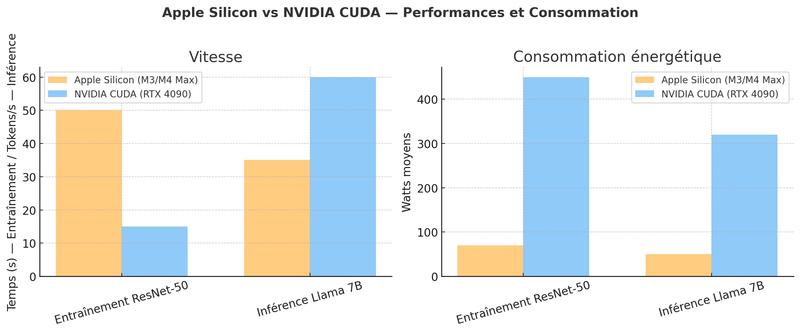

Les benchmarks réalisés sur des tâches standards, comme l’entraînement d’un ResNet-50 sur ImageNet ou de modèles Transformers de taille moyenne, confirment que les GPU NVIDIA haut de gamme conservent un avantage net en vitesse brute. Par exemple :

- Une RTX 4090 peut compléter une époque d’entraînement ResNet-50 en environ 15 secondes.

- Un M3 Max ou M4 Max réalise la même opération en 45 à 50 secondes.

Cet écart provient de la puissance de calcul parallèle largement supérieure des GPU NVIDIA, associée à des bibliothèques logicielles extrêmement optimisées (cuDNN, TensorRT, FlashAttention, etc.).

Cependant, l’efficacité énergétique change la perspective.

- M3/M4 Max : consommation entre 40 et 80 W en charge lourde.

- RTX 4090 : consommation pouvant atteindre 450 W.

Ainsi, à énergie égale, Apple Silicon accomplit davantage de travail par joule dépensé, ce qui peut représenter un avantage dans des environnements contraints en puissance ou en refroidissement.

En résumé :

- Choisir CUDA : pour l’entraînement massif de modèles de grande taille, nécessitant une vitesse maximale et des bibliothèques spécialisées.

- Choisir Apple Silicon : pour le prototypage rapide, les modèles de taille moyenne et les environnements où la consommation énergétique est un facteur clé.

2.2. Inférence

L’inférence, qui consiste à exécuter un modèle déjà entraîné, met davantage en valeur les forces d’Apple Silicon, en particulier pour les grands modèles de langage (LLMs) de taille moyenne ou importante.

Exemples pratiques :

- Llama 7B : un M3 Max peut générer 30 à 40 tokens par seconde avec un modèle quantifié, tout en restant silencieux et économe en énergie.

- Llama 13B : performances encore fluides, avec une latence du premier token très faible grâce à la mémoire unifiée.

- Llama 70B : possible sur un Mac Studio M2 Ultra avec 192 Go de RAM unifiée, à environ 8 à 12 tokens par seconde — ce qui serait impossible sur un seul GPU grand public.

En comparaison, CUDA conserve l’avantage en vitesse absolue pour l’inférence sur modèles massifs, mais Apple Silicon se démarque par sa capacité à exécuter localement des modèles qui dépasseraient la VRAM d’un GPU unique. La consommation est également très inférieure :

- M3 Max : ~50 W en génération LLM.

- RTX 4090 : souvent >300 W pour la même tâche.

En résumé :

- Apple Silicon excelle pour l’inférence locale, notamment sur des modèles 7B à 70B, avec un excellent compromis entre vitesse, consommation et silence.

- CUDA reste préférable lorsque la vitesse de génération est la priorité absolue, ou pour l’inférence en production à très grande échelle.

3. Outils et Frameworks

3.1. CUDA : Maturité et Optimisations Extrêmes

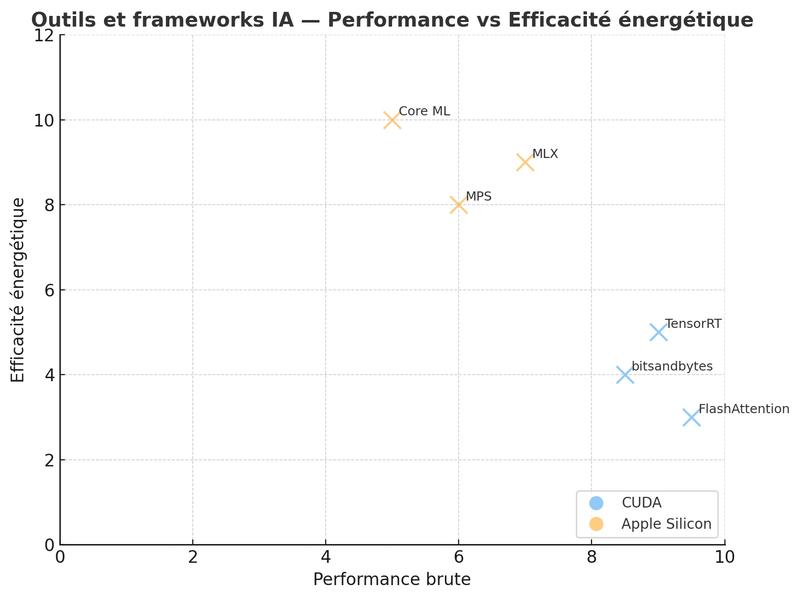

L’écosystème CUDA bénéficie de plus de quinze ans d’optimisations continues et d’une adoption massive dans l’industrie. Il propose un ensemble d’outils et de bibliothèques spécialisées qui exploitent pleinement les GPU NVIDIA, offrant des gains de performances significatifs pour l’entraînement et l’inférence :

- FlashAttention : implémentation optimisée du mécanisme d’attention des Transformers, réduisant la consommation mémoire et augmentant la vitesse, particulièrement efficace pour les LLMs.

- bitsandbytes : bibliothèque de quantization et d’optimisations mémoire (8 bits, 4 bits), indispensable pour manipuler de très grands modèles sur des GPU à VRAM limitée.

- TensorRT : moteur d’inférence haute performance, capable d’optimiser automatiquement les modèles pour obtenir des gains de vitesse substantiels.

La maturité de l’écosystème CUDA s’accompagne d’un support industriel massif. Les principaux fournisseurs de cloud (AWS, Azure, GCP, Oracle, etc.) proposent des machines virtuelles optimisées CUDA, permettant un déploiement direct en production. Les frameworks de référence comme PyTorch, TensorFlow et JAX sont optimisés en priorité pour CUDA, garantissant compatibilité et performances maximales.

3.2. Apple Silicon : MPS, MLX et Core ML

Apple Silicon s’appuie sur un ensemble d’outils qui, bien que plus récents que CUDA, progressent rapidement et exploitent les spécificités de l’architecture.

Metal Performance Shaders (MPS) MPS est la couche d’abstraction qui permet aux frameworks comme PyTorch et JAX de fonctionner sur Apple Silicon avec des modifications minimales du code. Il traduit les opérations GPU classiques en instructions Metal optimisées, en tirant parti de la mémoire unifiée et de la bande passante élevée. Les benchmarks montrent qu’un modèle comme ResNet-50 s’exécute environ 3 fois plus lentement qu’avec une RTX 4090, mais avec une consommation énergétique réduite de plus de 80 %.

MLX Framework natif conçu par Apple pour exploiter pleinement le SoC et ses unités spécialisées (GPU, AMX, Neural Engine). Il utilise une exécution différée (lazy evaluation) permettant de fusionner et d’optimiser les opérations avant leur exécution. Son API proche de NumPy facilite la prise en main et son intégration avec l’écosystème Python. Les tests montrent que MLX est particulièrement efficace pour l’inférence locale de modèles de langage, générant par exemple jusqu’à 50 tokens/s sur un Llama 3B quantifié en 4 bits avec un M3 Max.

Core ML Destiné principalement à l’intégration de modèles dans des applications macOS et iOS, Core ML permet d’exploiter au maximum le Neural Engine pour des performances élevées et une consommation minimale. Les modèles convertis en Core ML bénéficient d’optimisations automatiques (quantization, fusion d’opérations) et peuvent atteindre des latences inférieures à 5 ms pour certains réseaux légers.

En résumé, CUDA offre un écosystème extrêmement mature, pensé pour la performance maximale et la scalabilité dans le cloud, tandis qu’Apple Silicon mise sur l’intégration matérielle/logicielle et la simplicité d’exécution locale, avec un potentiel croissant au fil des mises à jour de MPS et MLX.

| Outil / Framework | Plateforme | Points forts | Limitations | Cas d’usage idéal |

|---|---|---|---|---|

| FlashAttention | CUDA | Accélération majeure des Transformers, réduction mémoire, très utilisé pour LLMs | Non disponible sur Apple Silicon | Entraînement ou inférence LLM haute performance sur GPU NVIDIA |

| bitsandbytes | CUDA | Quantization 8/4 bits, gain mémoire important, intégré à Hugging Face | Pas d’implémentation optimisée MPS | Chargement de modèles volumineux sur GPU avec VRAM limitée |

| TensorRT | CUDA | Optimisation automatique pour l’inférence, très rapide | Limité à NVIDIA | Déploiement haute performance dans le cloud ou en edge NVIDIA |

| MPS (Metal Performance Shaders) | Apple Silicon | Compatibilité PyTorch/JAX, zéro copie mémoire, bonne efficacité énergétique | Moins rapide que CUDA sur gros entraînements, certaines ops non supportées | Prototypage, entraînement léger à moyen, inférence locale |

| MLX | Apple Silicon | Framework natif optimisé, lazy evaluation, API proche de NumPy, excellente perf LLM | Jeune écosystème, moins d’outils tiers | Inférence locale optimisée, fine-tuning léger sur Mac |

| Core ML | Apple Silicon | Exploite le Neural Engine, optimisations automatiques, très faible consommation | Conversion préalable nécessaire, moins flexible pour R\&D | Déploiement dans apps macOS/iOS avec inférence temps réel |

4. Limites et Contraintes Spécifiques

Malgré ses atouts, Apple Silicon présente certaines limites qu’il est important de connaître avant d’engager un projet d’IA sur cette plateforme. Ces contraintes tiennent autant à l’architecture matérielle qu’à l’écosystème logiciel.

4.1. Containerisation et Accès GPU Metal

L’utilisation de conteneurs, notamment via Docker, reste problématique pour exploiter le GPU sur Apple Silicon. En effet, Metal, l’API graphique et de calcul d’Apple, nécessite un accès matériel direct que les conteneurs Linux exécutés dans une machine virtuelle ne peuvent pas obtenir. En pratique, cela signifie qu’un conteneur ne peut pas profiter du GPU ou du Neural Engine d’Apple Silicon. Les environnements de développement doivent donc souvent s’exécuter nativement sur macOS pour bénéficier de l’accélération matérielle, ce qui peut créer un décalage avec la production si celle-ci tourne sur Linux avec CUDA.

4.2. Boîte Noire du Neural Engine

Le Neural Engine est un accélérateur spécialisé très performant, mais son fonctionnement reste fermé. Contrairement à CUDA, qui permet d’écrire des kernels sur mesure, Apple ne donne pas d’accès direct à ce composant. Les développeurs doivent passer par Core ML ou des API compatibles, ce qui limite la flexibilité et rend certaines optimisations impossibles. Cette approche garantit stabilité et sécurité, mais peut freiner l’innovation dans des scénarios de recherche avancée.

4.3. Incompatibilités Partielles avec Certains Outils

Bien que PyTorch et JAX soient compatibles via MPS, certaines bibliothèques essentielles dans l’écosystème CUDA n’ont pas encore d’équivalent sur Apple Silicon. Parmi les plus notables :

- FlashAttention (attention optimisée)

- bitsandbytes (quantization 8/4 bits)

- Certaines implémentations accélérées de xFormers

Dans certains cas, les frameworks retombent sur des implémentations CPU plus lentes, entraînant une baisse de performance significative.

Transformers de Hugging Face sur Apple Silicon

1. Couverture MPS Incomplète et Bascules CPU

Le backend MPS (PyTorch sur Metal) n’implémente pas encore toutes les opérations. La doc officielle recommande d’activer le fallback CPU via PYTORCH_ENABLE_MPS_FALLBACK=1 ; par ailleurs, l’entraînement distribué n’est pas supporté sur MPS.

2. Stabilité/Performances de l’Attention

Des retours récents signalent des problèmes autour de scaled_dot_product_attention (SDPA) pouvant aller jusqu’au crash sur macOS/Apple Silicon, et des régressions mémoire côté MPS ont été suivies dans PyTorch en 2025. En pratique, beaucoup d’utilisateurs forcent l’implémentation “eager” de l’attention dans Transformers pour éviter les chemins non optimisés.

3. Pas d’Équivalents Directs pour Certaines Accélérations CUDA

Transformers sur Apple Silicon ne bénéficie pas des accélérations FlashAttention, de la librairie xFormers (kernels attention/SDPA) ni de bitsandbytes (quantization 8/4-bit) — cette dernière n’a pas de support MPS et n’est activée que si torch.cuda.is_available() est vrai. Conséquence : moins de débit et plus d’empreinte mémoire qu’avec CUDA pour les mêmes modèles.

- Any wizard could make Flash Attention to work with Apple …

- Accelerate and bitsandbytes is needed to install but I did

- M1.M2 MacOS Users · Issue #485 · bitsandbytes- …

4. Stabilisation en Cours… mais Alternatives Conseillées pour l’Inférence

Apple et PyTorch améliorent régulièrement MPS (optimisations d’attention, quantization, etc.), mais pour l’inférence locale de LLMs, MLX et les runtimes dédiés (llama.cpp, Ollama) restent souvent plus rapides et sobres sur Mac. Hugging Face documente désormais l’usage d’MLX et héberge des modèles au format MLX.

Bonnes pratiques minimales (Transformers + MPS)

- Définir

PYTORCH_ENABLE_MPS_FALLBACK=1pour éviter les erreurs d’opérations manquantes ; vérifier que le device est bienmps. - Forcer

model.config.attn_implementation="eager"lorsque l’attention optimisée pose problème. (Recommandation issue des retours terrain liés à SDPA/MPS.) - Éviter les dépendances CUDA-only (FlashAttention, bitsandbytes) dans un pipeline destiné au Mac ; envisager MLX/GGUF pour l’inférence quantifiée locale.

4.4. Limitation de la Mémoire GPU

Sur Apple Silicon, le GPU ne peut pas utiliser plus d’environ 75 % de la mémoire totale du système. Ainsi, un Mac doté de 128 Go de RAM ne pourra exploiter qu’environ 96 Go pour les tâches GPU. Cette restriction vise à préserver la stabilité du système, mais elle peut poser problème pour les modèles particulièrement volumineux. Les techniques de quantization ou de compression de modèles deviennent alors indispensables pour contourner cette limite.

En résumé, Apple Silicon offre un environnement performant et intégré, mais ces contraintes doivent être prises en compte dès la conception du projet. Elles influencent directement le choix des outils, l’architecture logicielle et la compatibilité avec les environnements de production traditionnels.

Comment composer avec ces contraintes

1. Conteneurs et GPU

- Effectuer le développement nécessitant le GPU directement sur macOS, en réservant Docker aux services annexes (API, bases de données).

- Tester OrbStack ou Colima pour des environnements ARM plus fluides que Docker Desktop (mais toujours sans accès GPU).

2. Neural Engine

- Convertir les modèles en Core ML pour tirer parti du Neural Engine.

- Privilégier des architectures déjà optimisées (Transformers, CNN courants) pour profiter des accélérations automatiques.

3. Incompatibilités Bibliothèques

- Utiliser des alternatives compatibles MPS (ex. :

mlx_lm,llama.cpp, Ollama) pour l’inférence LLM. - Éviter les dépendances critiques à des composants CUDA-only dans la phase de conception du projet.

4. Limite Mémoire GPU

- Employer la quantization (4 bits ou 8 bits) pour réduire l’empreinte mémoire.

- Charger les modèles en mode “lazy” ou par segments lorsque c’est possible.

- Prévoir des machines à plus grande RAM unifiée (96 à 192 Go) pour les modèles volumineux.

5. Cas d’Usage et Retours d’Expérience

5.1. Apple Intelligence et Private Cloud Compute

Apple met en pratique ses propres technologies Apple Silicon à grande échelle avec Apple Intelligence, introduit dans iOS 18 et macOS Sequoia. Les modèles utilisés sur les appareils sont optimisés pour fonctionner entièrement en local grâce au Neural Engine et au GPU intégré, garantissant ainsi confidentialité et faible latence. Pour les requêtes nécessitant des modèles plus volumineux, Apple s’appuie sur Private Cloud Compute, une infrastructure serveur basée sur des puces Apple Silicon personnalisées. Cette architecture conserve les mêmes principes que l’exécution locale — sécurité, chiffrement, et absence de collecte de données personnelles — tout en offrant la puissance nécessaire pour les traitements plus complexes.

5.2. Studios Vidéo et Production Créative

Plusieurs studios de post-production et de création vidéo utilisent désormais les Mac Studio ou Mac Pro à base de puces M2 Ultra ou M3 Ultra pour intégrer des tâches d’IA dans leurs workflows. Exemples concrets :

- Upscaling vidéo avec des outils comme Topaz Video AI.

- Génération et retouche d’effets visuels.

- Segmentation ou analyse d’images en temps réel pour l’édition et l’étalonnage.

Les bénéfices relevés par ces professionnels incluent une réduction de la consommation électrique (jusqu’à 4 fois moins que sur une station GPU classique), un bruit quasi nul dans les espaces de travail, et une capacité à charger en mémoire des modèles trop volumineux pour un GPU grand public.

5.3. Recherche Médicale et Analyse d’Images

Dans le domaine médical, certaines équipes utilisent Apple Silicon pour l’analyse d’images diagnostiques (radiographies, IRM, scanners) directement au sein d’outils locaux. L’architecture à mémoire unifiée permet de charger des modèles de segmentation complexes entièrement en RAM, offrant un traitement rapide et fluide, même sur des postes de travail hors centre de calcul. Cette approche est particulièrement appréciée dans les environnements cliniques, où le silence, la basse consommation et la sécurité des données sont prioritaires.

5.4. Communauté Open Source et Outils Locaux

La communauté open source a rapidement adopté Apple Silicon grâce à des projets optimisés pour macOS :

- Ollama : permet d’exécuter localement des modèles de langage variés avec une installation simple.

- llama.cpp : exécution optimisée des LLMs en C++ avec prise en charge Metal.

- MLX : bibliothèque Apple officielle, enrichie par de nombreux modèles pré-quantifiés disponibles sur Hugging Face.

Ces initiatives facilitent l’accès à des modèles de plusieurs milliards de paramètres sur Mac, sans infrastructure GPU dédiée. Les modèles quantifiés en 4 ou 8 bits permettent de réduire la mémoire nécessaire tout en maintenant une qualité proche de l’original, rendant possible l’exécution de modèles 7B à 70B directement sur un Mac équipé de suffisamment de RAM unifiée.

6. Perspectives

6.1. Roadmap Apple Silicon

Apple travaillerait sur une puce M5 attendue avant la fin de 2025, dotée de co‑processeurs spécifiques aux modèles Transformer, pour améliorer significativement les performances des LLM tout en conservant une très forte efficacité énergétique. De plus, l’entreprise développe ses propres solutions serveur (utilisées dans Private Cloud Compute), afin de réduire sa dépendance aux GPU NVIDIA dans ses datacenters.

6.2. Apple Container et Accès GPU dans les Conteneurs

Apple introduit une nouvelle approche de la containerisation native, espérant offrir des environnements plus isolés, plus rapides et mieux intégrés à macOS. Toutefois, la question de l’accès au GPU (via Metal) dans ces conteneurs ne trouve pas encore de solution officielle.

À ce jour, les conteneurs Docker classiques sur macOS ne peuvent pas exploiter le GPU ; torch.backends.mps.is_available() retourne systématiquement False à l’intérieur d’un conteneur (Stack Overflow). Cela étant dit, des avancées expérimentales avec Podman (via libkrun et un dispositif virtio‑gpu) permettent aujourd’hui de rediriger des appels Vulkan depuis un conteneur vers la GPU du système hôte. Cette solution fonctionne, certes avec du retard par rapport à l’exécution native, mais apporte un vrai gain comparée à l’exécution CPU seule (Red Hat Developer).

6.3. ARM dans l’IA : un Écosystème en Expansion

L’essor de l’architecture ARM pour l’IA est global. On observe des initiatives ambitieuses chez :

- Qualcomm, avec ses puces Snapdragon X pour PC et projets pour serveurs IA.

- Ampere Computing, déjà présent dans les clouds Azure, Oracle, etc.

- Huawei et Xiaomi, qui développent en Chine leurs propres SoC ARM pour réduire la dépendance aux technologies étrangères.

Cette tendance consolide l’idée que l’IA n’est plus l’apanage des GPU, et que les architectures intégrées, efficaces et sobres, ont un rôle crucial à jouer, notamment en edge computing.

6.4. Évolution des Frameworks et Outils

Le paysage logiciel autour d’Apple Silicon est en pleine maturation :

- MLX s’enrichit rapidement avec du quantization avancé (GPTQ, AWQ) et des outils de profiling intégrés.

- MPS et Core ML renforcent progressivement leur prise en charge côté PyTorch et JAX.

- Les projets open source comme llama.cpp ou Ollama renforcent leur support, garantissant des performances robustes même hors environnement CUDA.

En résumé, Apple Container est prometteur pour les workflows localisés, mais l’accès au GPU depuis un conteneur reste aujourd’hui limité. L’avenir semble en bonne voie, avec Podman offrant déjà une solution effective via libkrun. L’écosystème ARM, stimulé par Apple et d’autres acteurs, continue de se structurer, et les frameworks logicielles deviennent chaque jour plus pertinents pour les usages IA sur Mac.

Conclusion : Pour Développer une Application d’IA

Pour concevoir, tester et livrer une application d’IA, Apple Silicon et NVIDIA CUDA répondent à des besoins distincts :

- Apple se distingue pour le travail local : la mémoire unifiée, le silence en charge et l’efficacité énergétique offrent un environnement fluide pour prototyper, affiner l’expérience utilisateur et déployer des apps macOS/iOS avec Core ML ou MLX, tout en préservant la confidentialité des données sur l’appareil.

- À l’inverse, CUDA demeure le standard industriel pour bâtir des backends à grande échelle : l’écosystème outillé (TensorRT, Triton, multi-GPU) et la compatibilité cloud en font la référence quand la montée en charge, la disponibilité et les performances maximales sont prioritaires.

| Dimension produit | Avantage Apple Silicon | Avantage CUDA |

|---|---|---|

| Prototypage & itération locale | ✅ (rapidité, mémoire unifiée, silence) | |

| Apps client macOS/iOS (on-device) | ✅ (Core ML / MLX, confidentialité) | |

| Backends/API à l’échelle | ✅ (TensorRT, Triton, multi-GPU) | |

| Compatibilité écosystème & libs | ✅ (Transformers + FlashAttention, bitsandbytes…) | |

| Efficacité énergétique poste/edge | ✅ | |

| MLOps & cloud readiness | ✅ (standards, images, serveurs GPU) | |

| Containerisation avec accès GPU | (encore limité côté Mac, Apple Container à suivre) | ✅ (mature) |

| Confidentialité & conformité locale | ✅ (traitement on-device) |

Apple Silicon n’est pas un remplaçant total de CUDA, mais peut être un atout stratégique dans une architecture IA hybride.

Pour une équipe produit, l’approche la plus efficace consiste à prototyper et soigner l’expérience sur Apple Silicon, puis à industrialiser et passer à l’échelle sur CUDA quand l’application doit respecter des SLA exigeants.

Un mot sur le Décalage macOS (dev) / Linux (prod)

Dans l’état actuel, développer sur macOS et déployer en production sur des serveurs Linux n’est pas optimal et expose à plusieurs inconforts notables :

- Écart d’outillage et de bibliothèques : certaines optimisations majeures côté CUDA (p. ex. FlashAttention, bitsandbytes, kernels spécifiques) n’ont pas d’équivalent direct sur MPS/Metal, ce qui complique la parité de performances et de comportements.

- Différences d’architecture : arm64 sur Mac vs x86_64 en prod implique des variations de dépendances, de roues binaires et parfois de numérics, avec un risque de divergences subtiles entre environnements.

- Containerisation : l’accès GPU dans des conteneurs sur macOS reste limité ; les pipelines CI/CD reproduisant fidèlement l’exécution GPU de prod sont donc plus difficiles à mettre en place sur poste de développement.

- Formats et portabilité des modèles : les artefacts orientés Apple (Core ML/MLX) ne se transposent pas toujours directement vers les toolchains de prod (TensorRT/ONNX), et inversement, ce qui ajoute des étapes de conversion et de validation.

- Observabilité et profiling : les outils de profilage et de tracing diffèrent (Xcode/Metal vs Nsight/cu*), rendant les diagnostics moins comparables entre dev et prod.

En 2025–2026, plusieurs sujets méritent une veille active :

- La maturité de MLX et MPS progresse : couverture supplémentaire des opérateurs Transformers, outils de profilage, quantization,… peuvent réduire l’écart fonctionnel avec CUDA.

- L’évolution d’Apple Container et de l’accès GPU en environnements isolés sera déterminante pour des chaînes CI/CD cohérentes entre Mac en dev et serveurs Linux en prod.

- La disponibilité et le coût des GPU, ainsi que les alternatives (ROCm, Gaudi, ARM côté serveur), peuvent influencer les choix d’architecture.